Table des matières de l'article :

Le Crawl Budget ou Crawling Budget est un terme souvent mal compris dans le SEO et le marketing digital. Cela découle en grande partie d'un manque de compréhension du fonctionnement des moteurs de recherche.

Il existe actuellement environ un billion de pages sur le World Wide Web. L'organisation de ces pages et l'évaluation de leur valeur relative est l'une des tâches les plus difficiles auxquelles les moteurs de recherche sont confrontés.

C'est un problème pour les propriétaires de sites Web lorsque Googlebot n'explore pas toutes les pages de leur site Web. Lorsque cela se produit, cela est généralement dû à l'une des deux raisons suivantes :

- Google dispose de ressources limitées et a donc développé des mécanismes pour filtrer les pages de mauvaise qualité et les spams.

- Google limite souvent le nombre de pages qu'il explorera afin que votre serveur ne plante pas.

Ainsi, si Google consacre ses ressources à essayer d'explorer toutes les pages de votre site Web, y compris celles de mauvaise qualité, vos pages les plus précieuses risquent de ne pas être explorées. C'est pourquoi il faut optimiser votre budget de crawl .

Dans cet article, nous aborderons les principes fondamentaux de l'optimisation du budget d'exploration et aborderons les problèmes courants rencontrés par les propriétaires de sites Web lorsqu'ils rendent leurs pages plus explorables.

Qu'est-ce que le crawl budget ou crawl budget ?

Un budget de crawl est le nombre prédéterminé de requêtes qu'un crawler effectuera sur un site Web au cours d'une période donnée.

Ce nombre indique combien et quelles pages Googlebot explorera votre site Web.

Le budget de crawl est entièrement déterminé par le moteur de recherche. Une fois le budget épuisé, le robot d'indexation cesse automatiquement d'accéder au contenu de votre site et passe au site Web suivant.

La raison d'allouer des budgets de crawl aux sites Web est que les moteurs de recherche tels que Google peuvent explorer un nombre limité de pages Web. Pour prendre soin avec précision des millions de sites Web sur Internet, Google répartit ses ressources entre eux aussi équitablement que possible. Le budget de crawl de chaque site web est différent et dépend de plusieurs facteurs :

- Taille du site : Les sites Web plus grands se voient généralement allouer des budgets de crawl plus importants.

- Configuration du serveur et performances du site : Les temps de chargement du serveur et les performances du site sont également pris en compte lors de l'allocation de votre budget de crawl.

- Liens sur votre site : les structures de liens internes jouent un rôle vital, et les liens morts ou les chaînes de redirection peuvent épuiser votre budget de numérisation.

- Fréquence des mises à jour du contenu sur votre site : Google passe plus de temps à explorer des sites avec des mises à jour de contenu régulières.

L’importance du Crawl Budget pour le SEO

La gestion de votre budget de crawl n'est pas si cruciale pour les sites Web relativement petits avec seulement quelques pages, mais cela devient un problème pour ceux de taille moyenne ou plus grande.

Le référencement implique d'apporter de nombreux changements mineurs mais collectivement significatifs qui affectent la croissance de votre site Web au fil du temps, plutôt que d'apporter de grands changements pour obtenir des résultats rapides. Votre travail en tant que professionnel du référencement ou administrateur Web consiste à optimiser au maximum des milliers de petites choses.

Les moteurs de recherche ont des ressources limitées et ne peuvent pas explorer et indexer chaque page Web qu'ils trouvent sur un Internet immense et en constante évolution. C'est pourquoi le budget de crawl devient si important, en particulier pour les grands sites Web avec de nombreuses pages.

Alors que l'exploration est moins importante pour les webmasters avec des sites plus petits, même un site Web qui semble petit à première vue peut contenir des milliers d'URL. La navigation multi-facettes ou à facettes, ou tendanciellement par attributs et taxonomies, courante dans de nombreux magasins en ligne et sites de commerce électronique, peut facilement convertir 100 pages en 10.000 XNUMX URL uniques, ce qui peut devenir un problème lors de l'exploration et de l'indexation. De plus, la présence de bogues dans le CMS peut produire des résultats indésirables.

Pour les meilleures pratiques de référencement, il est généralement recommandé à tous les webmasters d'évaluer le budget de crawl de leur site Web, quelle que soit sa taille ou sa structure.

Comprendre le processus de numérisation

Comprendre ce qu'est un budget d'exploration et pourquoi il est important est une chose, mais les propriétaires de sites Web et les équipes de référencement doivent également comprendre comment Google explore les sites Web.

Comment fonctionnent les moteurs de recherche

Les moteurs de recherche comme Google utilisent trois processus de base pour cataloguer les pages Web : l'exploration, l'indexation et le classement.

Numériser : rechercher des informations

Les robots d'exploration des moteurs de recherche commencent par visiter des sites Web à partir de leur liste d'adresses Web obtenue à partir d'analyses et de plans de site précédents, fournis par divers webmasters via des outils tels que Google Search Console. Les robots utilisent ensuite les liens sur les sites pour découvrir d'autres pages.

Indexation : organisation de l'information

Par la suite, les crawlers organisent les pages visitées en les indexant. Le Web est essentiellement une bibliothèque géante qui s'agrandit à chaque minute sans système de stockage central. Les moteurs de recherche visualisent le contenu de la page et recherchent des signaux clés qui indiquent de quoi traite la page Web (par exemple, des mots clés). Ils utilisent ces informations pour indexer la page.

Classement : Informations sur le service

Une fois qu'une page Web a été explorée et indexée, les moteurs de recherche fournissent aux utilisateurs des résultats de requête basés sur l'algorithme de classement avec des pages indexées.

Les détails de l'analyse

Gary Illyes, Webmaster Trends Analyst chez Google, nous a donné une image plus claire de la Processus d'exploration de Googlebot dans un article de blog du 2017. Selon lui, le crawl budget repose principalement sur deux composantes : la limite de vitesse de numérisation et la question du scan

Limite de vitesse de numérisation

Une limite de vitesse d'exploration fait référence à la fréquence à laquelle votre site Web est exploré.

L'analyse consomme les ressources du serveur et les limites de bande passante attribuées au site par son hôte. C'est pourquoi les moteurs de recherche comme Google ont des systèmes pour déterminer la fréquence à laquelle vous visitez des sites Web, afin que le site puisse être exploré de manière durable.

Cela signifie qu'il existe une limite au nombre de fois qu'un site Web donné sera exploré. La limite de vitesse d'exploration empêche les robots d'exploration de perturber les performances de votre site Web en le surchargeant de requêtes HTTP. Cela permet aux moteurs de recherche de déterminer la fréquence à laquelle ils peuvent visiter votre site Web sans causer de problèmes de performances.

Ce procédé présente également des inconvénients. La définition manuelle de la limite de vitesse de numérisation peut entraîner des problèmes tels que :

- Fréquence de balayage faible - lorsque le nouveau contenu de votre site Web reste non indexé pendant de longues périodes

- Taux de balayage élevé - lorsque votre budget d'analyse mensuel est inutilement épuisé en raison d'analyses répétées de contenus qui ne doivent pas être analysés.

C'est pourquoi il est généralement conseillé aux administrateurs Web de laisser l'optimisation de la vitesse de crawl aux moteurs de recherche.

Application de numérisation

La demande d'exploration détermine le nombre de pages d'un site Web qu'un robot d'exploration visitera au cours d'une seule exploration. Elle est principalement influencée par les facteurs suivants :

- Popularité des URL - Plus une page reçoit de trafic, plus elle a de chances d'être indexée.

- Sortir ensemble Les pages dont le contenu est mis à jour régulièrement sont considérées comme de nouvelles URL et sont plus susceptibles d'être indexées que les pages dont le contenu est rarement mis à jour ou les "URL obsolètes".

Facteurs affectant votre budget de numérisation

De nombreux facteurs déterminent le budget de crawl, et nombre d'entre eux causent des problèmes récurrents aux propriétaires de sites Web. Comprendre ce qu'ils sont nous permettra d'avoir une sorte de liste que nous pourrons évaluer et examiner si notre site commence à souffrir de baisses d'indexation et de positionnement qui peuvent être symptomatiques d'erreurs plus ou moins graves qui peuvent presque toujours être résolues.

Navigation à facettes ou par attributs et taxonomies

Les sites Web de commerce électronique ont souvent des dizaines de variantes du même produit et doivent fournir un moyen de les filtrer et de les trier pour les utilisateurs. Ils le font à travers une navigation à facettes, créant des URL uniques et organisées pour chaque type de produit.

Bien que la navigation à facettes soit très utile pour les utilisateurs, elle peut créer un certain nombre de problèmes pour les moteurs de recherche. Les filtres appliqués créent souvent des URL dynamiques, qui apparaissent aux robots d'exploration Web comme des URL individuelles qui doivent être explorées et indexées. Cela peut épuiser inutilement votre budget de crawl et créer du contenu dupliqué sur votre site Web.

Identifiants de session et contenu dupliqué

Les paramètres d'URL tels que les ID de session ou les ID de suivi finissent par créer plusieurs instances uniques de la même URL. Cela peut également créer des problèmes de contenu en double qui nuisent au classement de votre site Web et épuisent votre budget d'appel.

Pages souples 404

Un soft 404 se produit lorsqu'une page Web corrompue répond avec un code d'état HTTP 200 OK au lieu d'un code de réponse 404 Not Found. Cela amène le robot à tenter une exploration sur cette page cassée et à consommer votre budget d'exploration. C'est une erreur assez grossière mais tout aussi populaire.

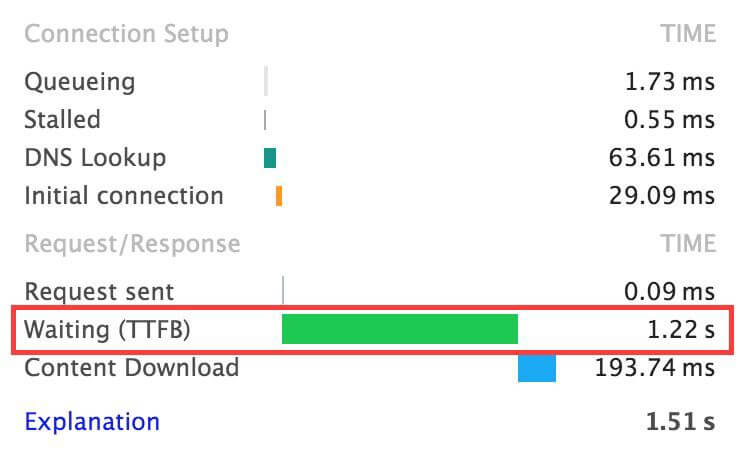

Mauvaise configuration du serveur et de l'hébergement

De mauvais résultats de configuration du serveur et de l'hébergement peuvent entraîner des plantages fréquents de votre site Web. La limite de vitesse d'exploration empêche les robots d'exploration d'accéder aux sites Web sujets aux plantages. Par conséquent, ils éviteront souvent les sites Web hébergés sur de mauvaises configurations de serveur.

En tant qu'hébergeur de Serveurs Dédiés et WordPress Hosting et WooCommerce Hosting avec des sites avec des millions de pages, on peut dire que très souvent la pile logicielle côté serveur n'est pas adéquate pour retourner du contenu rapidement et avec un Temps jusqu'au premier octet trop haut.

C'est grâce à une approche applicative avec un développement lean et performant, flanquée de Systèmes de mise en cache de niveau entreprise tels que Varnish Cache, que ces limites et criticités peuvent être surmontées.

CSS et JavaScript bloquant le rendu

Chaque ressource qu'un robot d'exploration Web récupère lors du rendu de votre page Web est prise en compte dans votre budget d'exploration, y compris non seulement le contenu HTML, mais également les fichiers CSS et JS.

Les webmasters doivent s'assurer que toutes ces ressources sont mises en cache par le moteur de recherche et minimiser les problèmes de performances et que les feuilles de style externes ne causent pas de problèmes tels que le fractionnement du code.

Liens brisés et redirections

Un lien brisé est un lien hypertexte Ahref qui redirige l'utilisateur ou le bot vers une page qui n'existe pas. Les liens brisés peuvent être causés par une URL incorrecte dans le lien ou une page qui a été supprimée. Lorsque 301 se redirige les uns vers les autres dans une séquence, cela peut frustrer les utilisateurs humains et confondre les robots des moteurs de recherche.

Chaque fois qu'un bot rencontre une URL redirigée, il doit envoyer une requête supplémentaire pour atteindre l'URL de destination finale. Ce problème devient d'autant plus grave qu'un site Web est grand. Un site Web avec au moins 500 redirections donne à un robot d'exploration un minimum de 1.000 XNUMX pages à explorer. Un lien redirigé peut envoyer un crawler à travers la chaîne redirigée, manquant de budget de crawl sur des sauts de redirection inutiles.

Vitesse du site et balises Hreflang

Votre site Web doit se charger suffisamment rapidement pour que le robot d'exploration puisse accéder efficacement à vos pages. Ces robots basculent souvent vers un site Web complètement différent lorsqu'ils rencontrent une page qui se charge trop lentement. par exemple, s'il a un temps de réponse du serveur supérieur à deux secondes.

En ce qui concerne la vitesse d'un site Web, beaucoup de choses ont été dites dans divers articles de notre blog étant en fait "l'hébergement géré par la performance" qui est la revendication qui nous distingue. Cependant bien qu'il y ait de nombreuses approches et possibilités pour accélérer un site, beaucoup dépend du CMS utilisé pour implémenter quelles sont les techniques classiques d'optimisation tant côté matériel que côté serveur et surtout côté applicatif.

Les URL alternatives définies avec la balise hreflang peuvent également épuiser votre budget de crawl.

Plan du site XML, alias le plan du site

Les moteurs de recherche comme Google donnent toujours la priorité à la planification de l'exploration des URL incluses dans votre sitemap par rapport à celles que Googlebot découvre lors de l'exploration de votre site. Cela signifie que la création et la soumission du plan de site XML de votre site Web aux webmasters de Google sont essentielles à la santé de son référencement. Cependant, l'ajout de chaque page au plan du site peut également être nuisible, car le crawler devant prioriser l'ensemble de votre contenu consomme votre budget de crawl.

Comment calculer le Crawl Budger ?

Le suivi et le calcul de votre budget de crawl sont délicats, mais cela peut vous donner des informations très précieuses sur votre site Web.

Tout d'abord, vous devez savoir combien de pages vous avez. Vous pouvez obtenir ce numéro à partir de votre plan de site XML, en interrogeant le site avec Google en utilisant site : yourdomain.com, ou en explorant votre site Web avec un outil comme Screaming Frog. Une fois que vous savez combien de pages Web vous avez, ouvrez la console de recherche Google pour votre site Web et recherchez le rapport Statistiques d'exploration dans la section Outils et rapports précédents.

Cela montre l'activité de Googlebot sur votre site au cours des 90 derniers jours. Ici vous pouvez trouver le nombre moyen de pages numérisées par jour. En supposant que le nombre reste cohérent, vous pouvez calculer le budget de crawl avec la formule suivante :

nombre moyen de pages numérisées par jour × 30 jours = budget de numérisation

Ces informations sont très utiles lorsque vous devez optimiser votre budget de numérisation. Divisez le nombre de pages de votre site Web par le nombre moyen de pages explorées par jour.

Si le résultat est un nombre supérieur à 10, cela signifie que vous avez 10 fois plus de pages sur votre site que Google crawls par jour, ce qui signifie que vous devez optimiser votre budget de crawl. Si le nombre est inférieur à 3, le budget de numérisation est déjà optimal.

Optimisation du budget de crawl

Optimiser le budget de crawl de votre site Web signifie simplement prendre les mesures appropriées pour l'augmenter. En améliorant quelques facteurs clés qui l'affectent, tels que la navigation à facettes, le contenu obsolète, les erreurs 404 et les chaînes de redirection 301, vous pouvez être sur la bonne voie pour augmenter le budget de crawl de votre site Web. C'est comme ça:

Optimiser la navigation faciale

La navigation multi-facettes peut grignoter votre budget de crawl si elle n'est pas correctement mise en œuvre, mais cela ne devrait pas vous empêcher de l'utiliser. Vous avez juste besoin de faire quelques ajustements pour l'optimiser.

- Vous pouvez ajouter une balise 'noindex' qui informe les bots des pages non indexées. Cela supprimera les pages de l'index mais continuera à gaspiller votre budget de crawl sur celles-ci.

- L'ajout d'une balise "nofollow" à n'importe quel lien de navigation à facettes empêchera le crawler de l'indexer, libérant ainsi le budget de crawl en supprimant immédiatement ces URL.

Supprimer le contenu obsolète

La suppression du contenu obsolète libérera une grande partie de votre budget d'exploration. Vous n'avez pas besoin de supprimer physiquement les pages qui contiennent ce contenu, il vous suffit d'empêcher les robots d'exploration d'y accéder comme vous l'avez fait avec les liens de navigation à facettes.

Cela réduirait le nombre d'URL crawlables dans votre index et augmenterait votre budget de crawl.

Réduire les codes d'erreur 404

Pour réduire le nombre de codes d'erreur 404 sur votre site Web, vous devez nettoyer vos liens brisés et envoyer un code de réponse 404 introuvable au robot d'exploration Web. Cela permet aux robots d'exploration d'éviter d'accéder à ces liens et, encore une fois, d'augmenter votre budget d'exploration en réduisant le nombre d'URL explorables pour votre site.

Résoudre les chaînes de redirection 301

Les liens brisés et les chaînes de redirection 301 peuvent également épuiser inutilement votre budget de crawl, et leur nettoyage devrait faire partie de la maintenance régulière de votre site Web. Pour éviter ce problème et augmenter votre budget de crawl, vous devez améliorer vos liens internes et corriger les chaînes de redirection en attente :

- Exécutez une analyse complète de votre site Web à l'aide d'un outil tel que Screaming Frog.

- Une fois l'exploration terminée, identifiez les URL redirigées et la page source où se trouve le lien spécifique.

- Enfin, mettez à jour ces liens afin que tous les liens pointent directement vers les URL de destination.

Vous devez également éviter les pages orphelines, qui sont présentes dans le plan du site mais ne sont pas liées en interne, les bloquant ainsi dans l'architecture de votre site Web.

Nettoyez et mettez à jour votre sitemap

Vérifiez votre sitemap à intervalles réguliers pour les URL non indexables incluses et pour les URL indexables qui en ont été exclues par erreur.

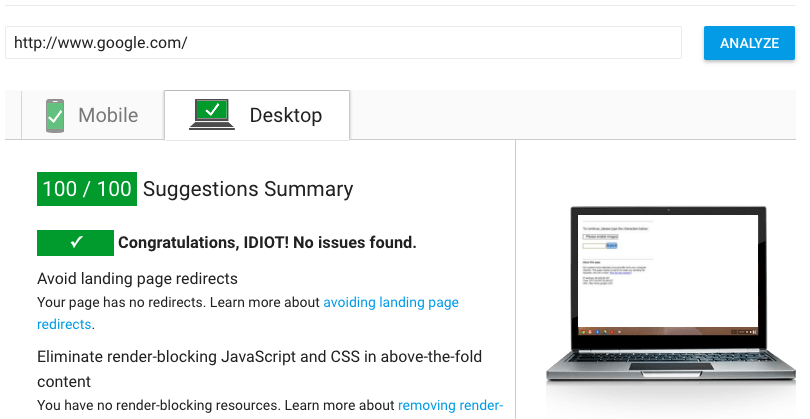

Améliorer la vitesse du site et la balise Hreflang

L'amélioration de la vitesse de votre site Web offre non seulement une meilleure expérience utilisateur, mais augmente également sa vitesse d'exploration. Les sites avec des vitesses de chargement lentes sont souvent complètement évités par Googlebot. L'optimisation de la vitesse des pages implique de nombreux facteurs techniques de référencement, mais leur exécution aide votre budget de crawl.

Vous pouvez voir par exemple comment il est possible d'augmenter la vitesse d'hébergement en utilisant notre service Optimisation Vitaux Web de base.

L'utilisation de dans l'en-tête de la page vous permet de mettre en évidence les versions localisées des pages pour le crawler et évite de manquer de budget de crawl.

Utilisez HTML si possible

Alors que Googlebot est devenu plus efficace pour explorer les fichiers JavaScript ainsi que pour indexer Flash et XML, ce n'est pas le cas avec d'autres moteurs de recherche populaires comme Bing ou DuckDuckGo. C'est pourquoi il est toujours conseillé d'utiliser le HTML dans la mesure du possible, car tous les robots des moteurs de recherche peuvent facilement explorer les fichiers HTML.

Utilisez Robots.txt pour analyser les pages importantes

L'utilisation du fichier robots.txt de votre site Web est un moyen très efficace d'optimiser votre budget de crawl. Vous pouvez gérer votre fichier robots.txt pour autoriser ou bloquer n'importe quelle page de votre domaine. Faire cela avec un vérificateur de site Web est recommandé pour les sites Web plus importants où des étalonnages fréquents sont nécessaires.

Utilisez des services d'indexation instantanée comme Index Now

IndexNow est un moyen facile pour les propriétaires de sites Web de informer instantanément les moteurs de recherche des dernières modifications apportées au contenu de leur site Web. Dans sa forme la plus simple, IndexNow est un simple ping permettant aux moteurs de recherche de savoir qu'une URL et son contenu ont été ajoutés, mis à jour ou supprimés, permettant aux moteurs de recherche de refléter rapidement ce changement dans leurs résultats de recherche.

Sans IndexNow, cela pourrait prendre des jours ou des semaines aux moteurs de recherche pour constater que le contenu a changé, car les moteurs de recherche n'explorent pas souvent toutes les URL. Avec IndexNow, les moteurs de recherche connaissent instantanément "les URL qui ont changé, ce qui les aide à hiérarchiser l'exploration de ces URL et limite ainsi l'exploration organique pour découvrir de nouveaux contenus".

IndexNow est particulièrement utile si votre site a besoin de se classer très rapidement, et surtout si votre site est un blog ou un journal en ligne ou un journal éditorial.

Utilisez nos services d'hébergement pour optimiser votre budget de crawl.

L'optimisation du budget de crawl est une science inexacte qui implique de nombreuses pièces mobiles et des tâches de maintenance continues du site Web qui peuvent être très lourdes.

L'utilisation de l'hébergement de serveur géré optimisé permet à Google d'explorer et d'indexer facilement votre site Web , qu'il soit réalisé en HTML ou en JavaScript et quel que soit le nombre de pages Web dont il dispose. Lorsque vous automatisez le processus d'optimisation du budget de crawl de votre site Web, vous libérez de la bande passante mentale pour des tâches plus importantes qui se concentrent sur une stratégie de référencement de niveau supérieur.